微语对接大模型Qwen3指南

在本篇博客中,我们将介绍如何将微语客服系统对接通义千问Qwen3大模型,使您的客服系统拥有强大的AI能力。通过这个集成,您可以为用户提供更智能、更高效的自动化客服体验。

Qwen3大模型介绍

通义千问Qwen3是阿里云推出的大型语言模型,具有强大的理解能力和生成能力。Qwen3系列模型在多轮对话、文本生成、问答解析等方面表现出色,非常适合客服场景应用。

Qwen3是千问系列大语言模型的最新一代,提供了全��面的稠密模型和混合专家模型(Mixture-of-Experts,MoE)。您可以访问Ollama官方库获取更多详细信息。

目前Qwen3系列提供多种不同参数规模的模型版本,以适应不同的应用场景和硬件环境:

- Qwen3-tools: 针对工具使用进行特别优化的版本

- Qwen3-0.6b: 超轻量版本,适合资源受限场景

- Qwen3-1.8b: 轻量级模型,平衡性能和资源消耗

- Qwen3-4b: 中小型模型,提供更好的理解力

- Qwen3-8b: 中型模型,具有较强的推理能力

- Qwen3-14b: 较大模型,提供优秀的理解和生成能力

- Qwen3-30b: 大型模型,适合复杂任务处理

- Qwen3-32b: 高性能大模型,强大的多任务能力

- Qwen3-234b: 超大规模模型,顶级性能表现

在本指南中,我们将使用Qwen3-4b版本进行演示,这是一个非常平衡的选择,既能提供良好的对话质量,又不会对普通设备造成过大负担。

一、Ollama安装Qwen3

Ollama是一个开源的大模型运行框架,可以在本地部署运行多种大型语言模型,包括Qwen3。下面是安装和配置步骤:

1. 安装Ollama

根据您的操作系统,选择相应的安装方法:

MacOS:

curl -fsSL https://ollama.ai/install.sh | sh

Linux:

curl -fsSL https://ollama.ai/install.sh | sh

Windows: 从Ollama官网下载并安装Windows版本。

2. 拉取Qwen3模型

安装完成后,通过命令行拉取Qwen3模型:

# 拉取Qwen3 4b模型

ollama pull qwen3:4b

# 如果需要更大参数的模型,也可以选择其他版本

# ollama pull qwen3:8b

# ollama pull qwen3:14b

3. 验证模型安装

通过以下命令验证Qwen3模型是否安装成功:

ollama list

您应该能看到已下载的qwen3模型列表。

4. 启动Ollama服务

确保Ollama服务正在运行:

# 在某些系统上,安装后会自动启动服务

# 如果没有自动启动,请使用以下命令

ollama serve

默认情况下,Ollama服务会在http://localhost:11434端口运行。

二、在微语管理后台设置Qwen3对话模型

完成Ollama和Qwen3模型的安装后,我们需要在微语管理后台进行配置:

1. 登录微语管理后台

访问您的微语管理后台,输入账号和密码登录系统。

2. 导航到AI设置

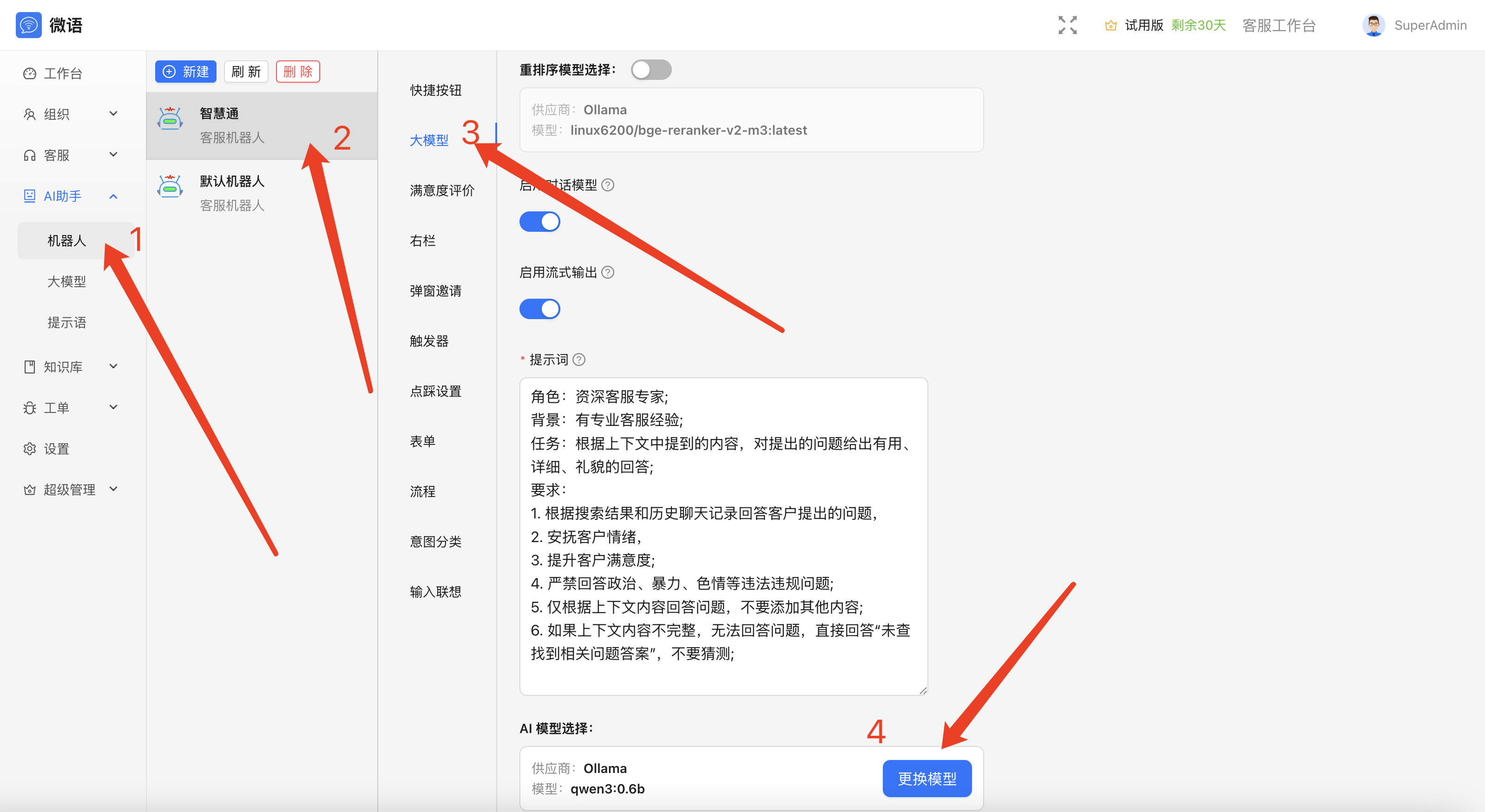

在左侧导航栏中,找到并点击"AI助手"->"机器人"选项。

图1:导航到AI设置

图1:导航到AI设置

3. 切换Qwen3模型配置

在AI设置页面中:

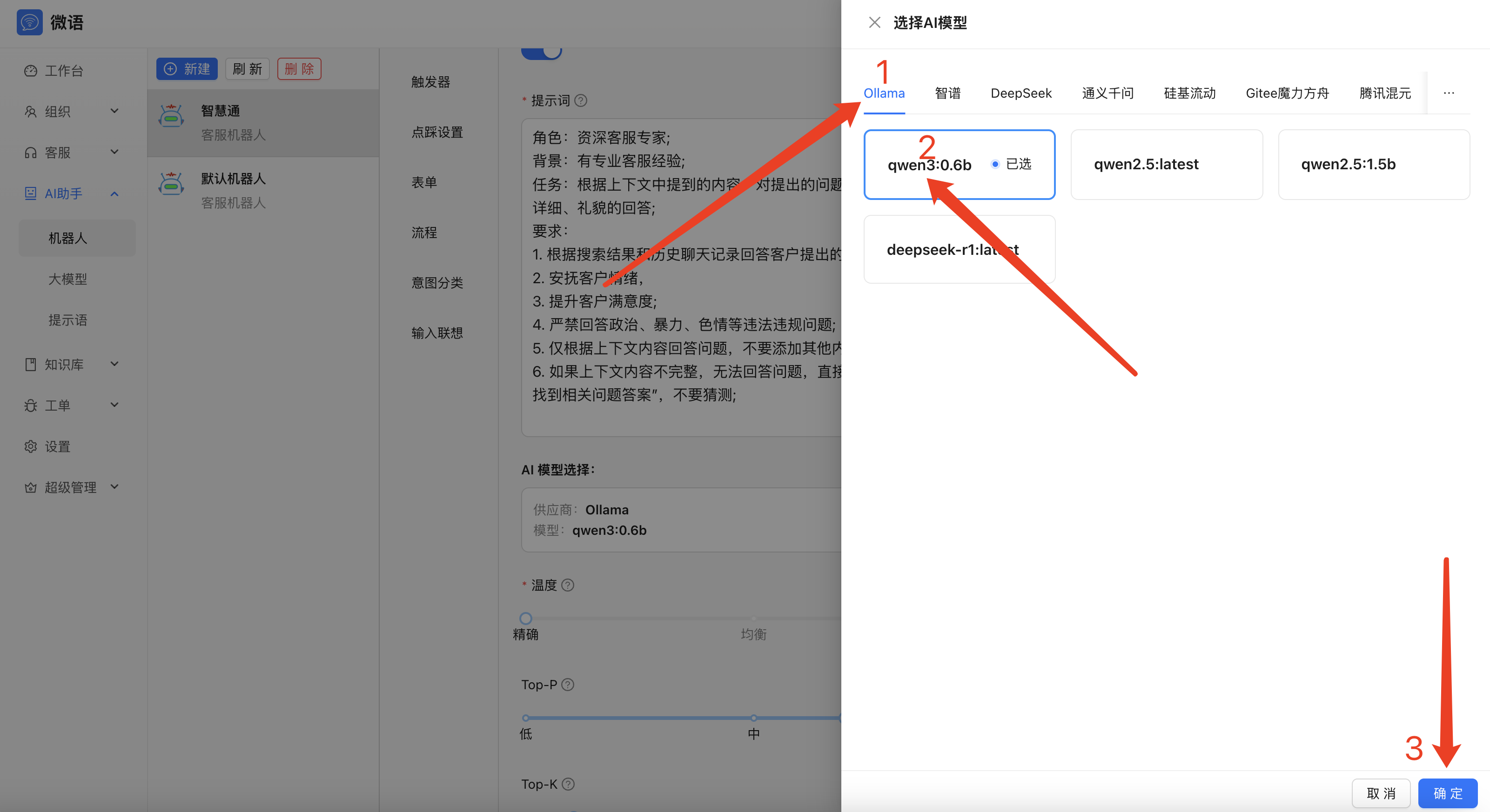

图2:切换Qwen3模型配置

图2:切换Qwen3模型配置

- 点击"AI模型选择"按钮

- 选择模型类型为"Ollama->Qwen3"

- 确认无误后,点击"确定"按钮

三、开始使用Qwen3进行智能对话

配置完成后,您可以开始体验Qwen3赋能的智能客服功能:

1. 创建知识库(可选)

为了让AI回答更加准确,您可以创建和维护特定领域的知识库:

- 导航到"知识库"或"AI训练"模块

- 点击"新建知识库",输入名称和描述

- 上传文档或手动添加Q&A对,丰富AI的专业知识

2. 测试对话效果

您可以通过以下方式测试Qwen3的对话能力:

- 在管理后台的"对话测试"功能中,输入问题进行测试

- 通过客服端应用,模拟用户提问,验证AI回复效果

- 通过访客端,体验实际用户视角下的AI交互

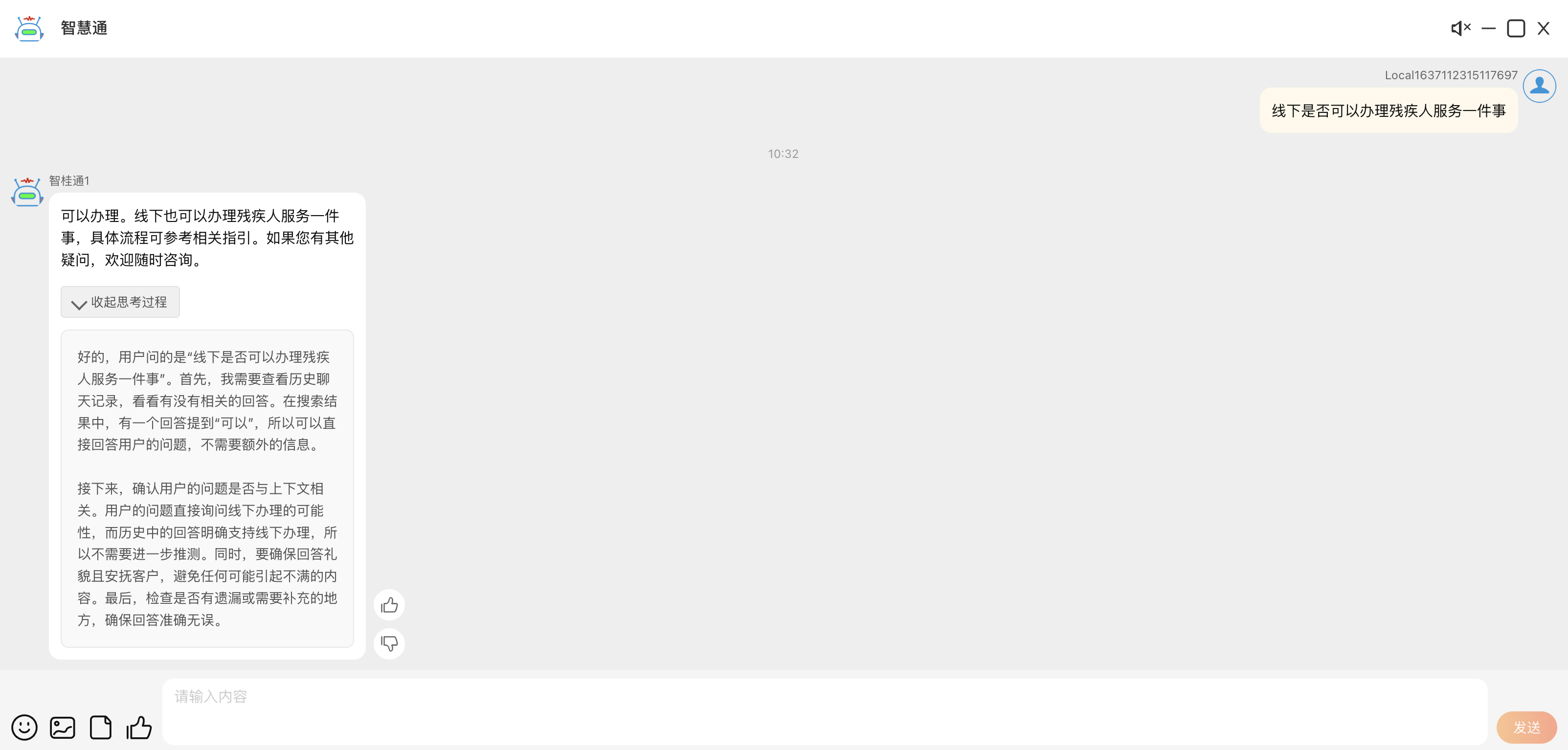

3. 对话效果展示

以下是一些使用Qwen3进行智能对话的演示截图:

图3:Qwen3能够根据上下文提供连贯的多轮对话

图3:Qwen3能够根据上下文提供连贯的多轮对话

四、优化和调整

为了获得最佳的Qwen3对话效果,您可以进行以下优化:

1. 调整模型参数

根据实际需求调整模型参数,如温度值、最大token数等,以平衡回答的创造性和精确性。

2. 优化系统提示词

系统提示词对AI的行为有重要影响,您可以根据业务场景定制专业的提示词,引导AI表现出理想的对话风格。

3. 结合人工审核

设置人工干预机制,对AI无法准确回答的问题进行人工接管,并将这些案例记录下来用于进一步训练和优化。

总结

通过将微语客服系统与通义千问Qwen3大模型对接,您可以显著提升客服自动化水平和用户体验。本指南详细介绍了从安装Ollama、配置Qwen3模型到实际应用的完整流程。

随着您不断优化提示词和积累领域知识库,AI助手的表现会越来越符合您的业务需求,为客户提供更加专业、高效的服务体验。

如有任何问题��或需要进一步的技术支持,请随时联系我们的技术团队。

希望本指南对您成功部署和使用微语+Qwen3智能客服系统有所帮助!